Matrices de confusión

| ||||||

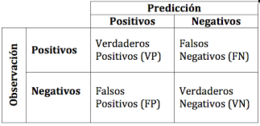

Matrices de confusión. La matriz de confusión es una herramienta fundamental a la hora de evaluar el desempeño de un algoritmo de clasificación, ya que dará una mejor idea de cómo se está clasificando dicho algoritmo, a partir de un conteo de los aciertos y errores de cada una de las clases en la clasificaión. Así se puede comprobar si el algoritmo está clasificando mal las clases y en qué medida.

Funcionamiento

La matriz de confusión es una herramienta fundamental a la hora de evaluar el desempeño de un algoritmo de clasificación, ya que dará una mejor idea de cómo se está clasificando dicho algoritmo, a partir de un conteo de los aciertos y errores de cada una de las clases en la clasificaión. Así se puede comprobar si el algoritmo está clasificando mal las clases y en qué medida.

El desempeño de un sistema es usualmente evaluado usando los datos en dicha matriz. La siguiente tabla muestra la matriz de confusión para un clasificador en dos clases:

| Clasificador | |||

|---|---|---|---|

| Negativos | Positivos | ||

| Valores reales | Negativos | a | b |

| Positivos | c | d |

En dicha tabla:

- a es el número de predicciones correctas de que un caso es negativo.

- b es el número de predicciones incorrectas de que un caso es positivo, o sea la predicción es positiva cuando realmente el valor tendría que ser negativo. A estos casos también se les denomina errores de tipo I.

- c es el número de predicciones incorrectas de que un caso es negativo, o sea la predicción es negativa cuando realmente el valor tendría que ser positivo. A estos casos también se les denomina errores de tipo II.

- d es el número de predicciones correctas de que un caso es positivo.

Han sido definidos varios términos estándar para medir el desempeño de un clasificador en cualquier rama donde se apliquen sistemas de clasificación:

- La Exactitud (Ac, del inglés Accuracy) es la proporción del número total de predicciones que fueron correctas:

- La Razón de Verdaderos Positivos (TPrate, del inglés True Positive Rate), a veces también denominada Recall, es la proporción de casos positivos que fueron correctamente identificados:

- La Razón de Falsos Positivos (FPrate, del inglés False Positive Rate) es la proporción de casos negativos que han sido incorrectamente clasificados como positivos:

- La Razón de Verdaderos Negativos (TNrate, del inglés True Negative Rate) es la proporción de casos negativos que han sido correctamente clasificados

- La Razón de Falsos Negativos (FNrate, del inglés False Negative Rate) es la proporción de casos positivos que fueron incorrectamente clasificados como negativos:

- La precisión (P, en inglés, también Precision) es la proporción de casos predichos positivos que fueron correctos

Frecuentemente son utilizados también los términos siguientes:

- Sensibilidad (Se, del inglés Sensitivity) como sinónimo de TPrate porque es la capacidad del clasificador de ser “sensible” a los casos positivos. Note que 1-Se=FNrate

- Especifidad (Sp, del inglés Specificity) como sinónimo de TNrate, porque puede dar una medida de la especificidad del test para marcar los casos positivos. Note que 1-Sp =FPrate

Si un clasificador puede variar determinados parámetros puede lograrse incrementar los TP a costa de incrementar los FP o viceversa. En otras palabras, se desea una alta sensibilidad con una gran especificidad (o equivalentemente una reducida FPrate)

Calculo en R

En R (R Core Team, 2017) se pueden calcular matrices de confusión con la función random Forest() de la librería randomForest que entre sus salidas entrega una matriz de confusión, además la librería caret tiene implementada la función confusionMatrix().

Fuentes

- Dougherty J, Kahavi R y Sahami M. Supervised and unsupervised discretization of continuous features. En Machine Learning: Proceedings of the Twelth International Conference, 1995

- Cuadras, C. M. (1981). Métodos de Análisis Multivariante. Eunibar. D.L. XII: 642

- Fawcett, T. (2003) ROC Graphs: Notes and Practical Considerations for Data Mining Researchers, Hewlett-Packard Company.

- Gower JC (1971) A general coefficient of similarity and some of its properties. Biometrics 27:857-871

- Johnson, D. E. (2000). Métodos Multivariados aplicados al análisis de datos. S.A. International Thomson Editores.

- Kohavi, R., and Provost, F. (1998), Glossary of Terms, Editorial for the Special Issue on Applications of Machine Learning and the Knowledge Discovery Process, Vol 30, No 2/3, Feb/March 1998.

- Maimon, O. and Rokach,L. (2005) Data Mining and Knowledge Discovery Handbook, Springer US, 2005.

- Podani J, Schmera D (2006) On dendrogram-based measures of functional diversity. Oikos 115:179-185

- Provost, F. and Fawcett, T. (2001). Robust classification for imprecise environments, Machine Learning 42: 203–231.

- R Core Team. 2017. R: A Language and Environment for Statistical Computing. Vienna, Austria: RFoundation for Statistical Computing. https://www.R-project.org/.

- Smith L, A Tutorial on Components Analysis, Tech. report, Universidad de Otago (Nueva Zelanda), 2002

- Sneath, P. H. A. y R. R. Sokal (1973). Numerical taxonomy. The principles and practice of numerical classification. San Francisco, California, EE.UU., W. H. Freeman and Co.

- Sokal, R. R. y P. H. A. Sneath (1963). Principies of numerical taxonomy. San Francisco y Londres, Freeman and Cía.

- Weiss, G. M., and Provost, F. (2003) Learning When Training Data are Costly: The Effect of Class Distribution on Tree Induction, JAIR 19, 315–354